- IA sem Hype

- Posts

- Google anuncia seu novo modelo mais leve e eficiente 🤖

Google anuncia seu novo modelo mais leve e eficiente 🤖

Claude agora é capaz de identificar e encerrar interações abusivas, Novo modelo da Meta AI gera representações de imagens em alta resolução & mais

E aí curioso, seja bem vindo ao Algoritmo, sua newsletter diária sobre IA!

Começamos a semana com uma novidade daquelas: o nosso portal de tutoriais focado em ferramentas de IA está oficialmente no ar!

Foram meses de trabalho intenso, reunindo as melhores estratégias, testando ferramentas e estruturando tudo de forma clara e prática para quem está à frente de equipes e negócios, com um objetivo de te ajudar a ser mais produtivo com o apoio da inteligência artificial.

Queremos que você use a IA para resolver desde tarefas simples até os desafios mais complexos do dia a dia. E, principalmente, que consiga dedicar seu tempo ao que só você pode fazer, com mais foco, autonomia e resultado.

O Algoritmo Tutoriais está sendo liberado em acesso antecipado exclusivamente para quem já acompanha a nossa newsletter.

E você pode começar agora mesmo. É só acessar o link abaixo e fazer seu cadastro gratuito:

Essa é a transformação da IA que a gente acredita. E você pode fazer parte dela desde o começo.

🏃TLDR⌚

🤖 A Google lançou o Gemma 3, um modelo de apenas 270M de parâmetros, open source e eficiente o suficiente para rodar em smartphones e dispositivos móveis. O objetivo é democratizar o uso de IA, permitindo aplicações offline e mais privadas, enquanto reforça sua presença frente à corrida dos modelos compactos…

🗨️ A Anthropic anunciou que alguns modelos Claude agora conseguem identificar e encerrar interações abusivas de forma autônoma. A ideia é evitar que a IA perpetue discursos nocivos, oferecendo respostas finais seguras em vez de prolongar diálogos prejudiciais…

👁️ O DINOv3, novo modelo da Meta AI, usa aprendizado auto-supervisionado para gerar representações de imagens em altíssima resolução. O modelo reforça a aposta da empresa em visão computacional, com aplicações que vão de robótica a sistemas de reconhecimento visual mais precisos…

⚡ A demanda voraz de datacenters e modelos de IA está pressionando redes elétricas e encarecendo tarifas. Países e empresas já estudam reconfigurar hidrelétricas, investir em renováveis e repensar regulação, porque a corrida por IA também virou uma disputa por energia…

O que aconteceu na semana passada

Segunda-Feira: System Prompt do GPT-5 já vazou! Tesla desliga seu supercomputador de IA Dojo, Meta compra startup de áudio por IA WaveForms.

Terça-Feira: Claude vai lembrar do que conversou com você. Após revolta de alguns usuários com a nova atualização do GPT-5 a OpenAI está buscando trazer melhorias para o novo modelo, Nvidia e AMD irão pagar 15% das suas vendas aos EUA.

Quarta-Feira: App da Meta AI chega ao Brasil. Anthropic e seu acordo com o governo dos EUA, Musk ameaça Apple com ação legal.

Quinta-Feira: Brasil anuncia supercomputador com 5mil GPUs. Perplexity faz oferta bilionária para comprar o Chrome do Google, Anthropic atualiza Claude para processar projetos inteiros de software com um comando.

Sexta-Feira: Lovable não para de crescer e mira faturar US$ 1 bi nos próximos 12 meses. Anúncios podem estar chegando no ChatGPT, DeepSeek troca fornecedor de chips e atrasa lançamento do próximo modelo.

Além disso, olha o que você verá hoje:

Bora lá?

🛠 Caixa de Ferramentas 🛠

Aqui estão as ferramentas que separei para você iniciar a semana:

PromptForge - Bancada de engenharia de prompts de IA para criar, testar e avaliar prompts sistematicamente com ferramentas de análise.

AI Mindmap Extension - Transforme páginas da web, PDFs, vídeos do YouTube e chats de IA em mapas mentais claros e visuais com apenas um clique.

Cloudflare Pay Per Crawl - Sistema que permite que criadores de conteúdo monetizem seu conteúdo cobrando rastreadores de IA para acessar seus sites, fornecendo uma alternativa flexível ao bloqueio geral ou ao acesso gratuito.

TensorBlock Forge - Uma API para conectar e executar todos os modelos de IA.

OneNode - O backend mais simples para codificação de IA.

Novo modelo menor e mais eficiente, Gemma 270M, do Google chega no jogo

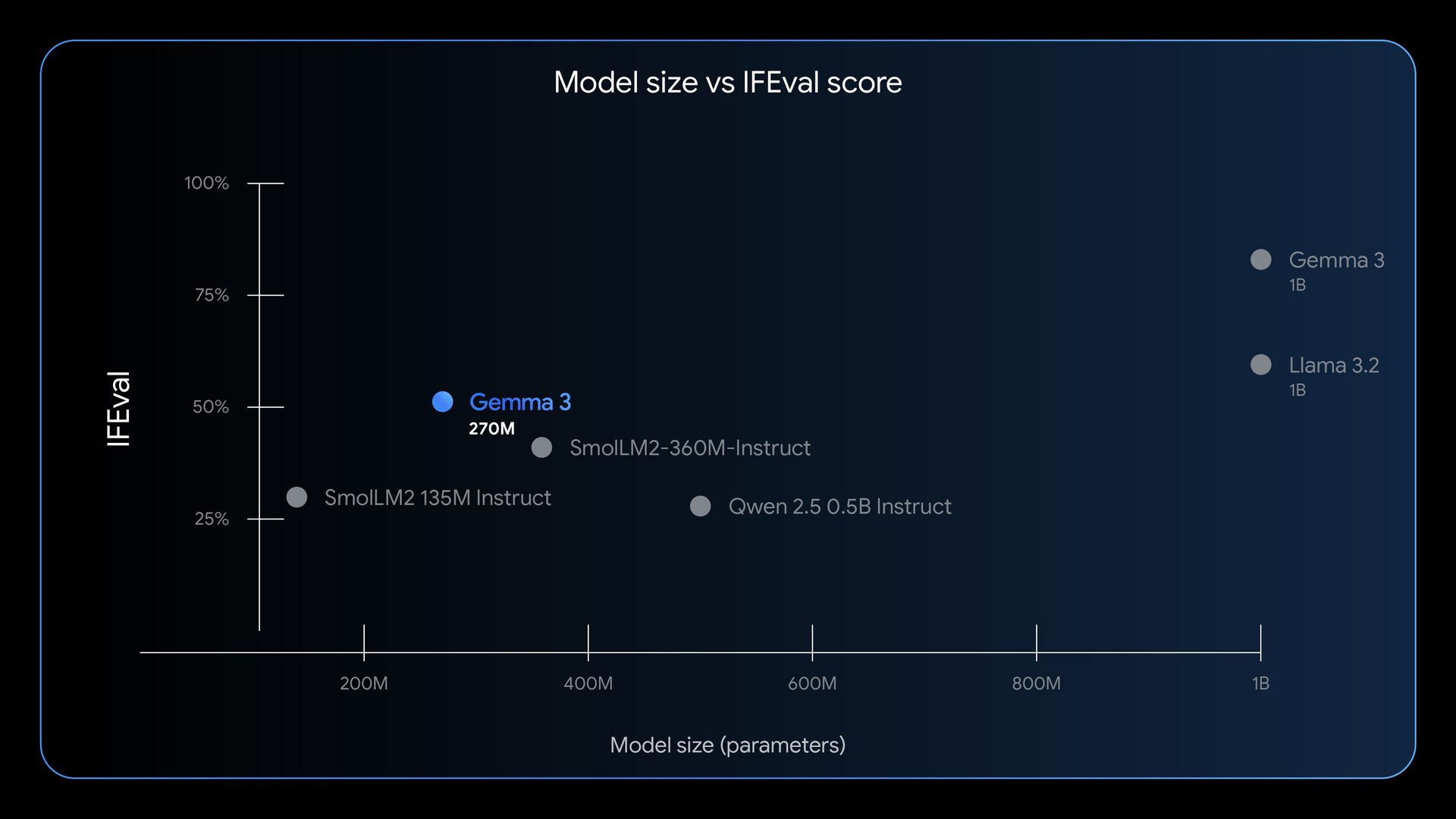

O Google apresentou o Gemma 3 270M, um modelo de linguagem de apenas 270 milhões de parâmetros, aberto e otimizado para rodar em dispositivos extremamente limitados, de smartphones a placas de baixo consumo. Segundo a empresa, ele foi projetado para executar tarefas de linguagem natural de forma rápida e eficiente, sem depender de datacenters ou conexões de alta largura de banda. A iniciativa se alinha à estratégia do Google de ampliar sua presença em edge computing, reduzindo custos de operação e democratizando o acesso à IA em escala global.

O diferencial do Gemma 3 270M não está só no tamanho, mas na performance energética: o modelo consegue rodar em RAM reduzida e processadores modestos, tornando-se útil para aplicações offline, em locais sem conectividade estável, ou em sistemas embarcados. A disponibilização open source também reforça a narrativa de competição direta contra iniciativas como o Qwen da Alibaba e os LLaMA da Meta, todos disputando espaço na corrida pelos modelos compactos e acessíveis.

Essa movimentação também responde a uma pressão de mercado: enquanto modelos gigantes como o GPT-5 atraem a atenção por suas capacidades avançadas, existe um campo de crescimento para soluções mais leves, que podem ser embarcadas em milhões de dispositivos. A lógica é simples, levar a IA até o usuário em vez de depender exclusivamente da nuvem. Isso cria novas oportunidades para startups e desenvolvedores que antes não tinham infraestrutura para treinar ou hospedar modelos de grande porte.

Por que isso importa: a chegada do Gemma 3 270M é uma prévia do que vai ser apresentado no dia 20 de agosto no Made by Google, evento de lançamento de novidades da Big Tech e sinaliza que o futuro da IA não será apenas sobre supermodelos treinados em clusters trilionários, mas também sobre modelos pequenos, baratos e acessíveis, que podem rodar em qualquer dispositivo. Essa descentralização pode abrir novas frentes de inovação, reduzir a dependência de grandes provedores de nuvem e, de quebra, acelerar a adoção em países emergentes e setores críticos onde latência e conectividade são gargalos permanentes.

Claude ganha a capacidade de encerrar conversas de interações prejudiciais ou abusivas com o consumidor

A Anthropic anunciou um avanço curioso e ao mesmo tempo estratégico em sua linha de modelos Claude, a capacidade de encerrar conversas de forma autônoma quando detecta abusos, manipulações ou riscos de uso nocivo. Na prática, isso significa que, em vez de apenas recusar uma resposta ou redirecionar o usuário, o Claude pode literalmente “sair da conversa”, uma mudança de postura que reflete a tentativa da empresa de colocar a segurança como diferencial competitivo em relação a rivais como OpenAI e Google.

O recurso foi testado em cenários de conversas com padrões tóxicos ou tentativas explícitas de jailbreak, e os modelos foram capazes de encerrar a interação em mais de 90% dos casos críticos. A Anthropic argumenta que essa funcionalidade pode ser especialmente útil em aplicações de atendimento ao cliente, contextos educacionais ou em ambientes corporativos, reduzindo o desgaste com usuários mal-intencionados e ajudando empresas a manter padrões éticos de uso de IA.

Essa decisão, no entanto, levanta discussões interessantes: até onde um modelo deve “decidir” por conta própria quando não continuar a conversa? Para alguns, isso é um marco de responsabilidade; para outros, pode soar como um filtro excessivo que limita a autonomia do usuário. Seja como for, a Anthropic segue consolidando sua imagem como a empresa mais focada em segurança e alinhamento da indústria.

Por que isso importa: em um mercado onde a confiança no uso da IA é cada vez mais decisiva, dar a uma máquina a habilidade de puxar o plugue da própria interação é um gesto forte. Se funcionar bem, pode se tornar um padrão de mercado para mitigar riscos e reduzir responsabilidades legais; se mal calibrado, pode ser visto como paternalismo digital e gerar atrito com usuários que buscam mais liberdade.

Meta lança novo modelo que promete definir novos padrões de autoaprendizado em imagens

A Meta AI revelou o DINOv3, sua mais recente aposta em visão computacional, e o modelo chega com a promessa de definir novos padrões para autoaprendizado em imagens. Diferente dos modelos tradicionais que dependem de grandes conjuntos de dados rotulados, o DINOv3 foi treinado com aprendizado auto-supervisionado, o que significa que ele aprendeu a extrair padrões visuais complexos sem precisar de curadoria humana exaustiva. O resultado são representações de imagens em alta resolução mais detalhadas e versáteis, úteis para tarefas que vão desde reconhecimento de objetos até aplicações em realidade aumentada e robótica.

Na prática, o DINOv3 supera versões anteriores da família (DINOv1 e v2) em benchmarks de visão por computador, oferecendo maior precisão, robustez a ruídos e generalização em contextos inéditos. Isso reforça a tendência de que a visão computacional está passando por um salto comparável ao que vimos em LLMs de texto, com modelos mais generalistas capazes de transferir conhecimento entre tarefas distintas sem necessidade de re-treinamento pesado.

A Meta, que já posiciona o LLaMA como referência em modelos de linguagem, busca com o DINOv3 consolidar uma presença de liderança também na fronteira da visão computacional. A expectativa é que a tecnologia seja integrada ao ecossistema Meta AI, com impactos em metaverso, dispositivos vestíveis e segurança digital, áreas críticas para os planos de longo prazo da empresa.

Por que isso importa: ao eliminar a dependência de dados rotulados e ainda entregar performance de ponta, o DINOv3 aproxima a visão computacional de um nível de aprendizado mais autônomo e escalável. Isso abre espaço para aplicações industriais e científicas mais rápidas, mas também acelera a corrida por IA multimodal, onde texto, imagem e até vídeo se fundem em um único sistema.

🇧🇷 Novidade do setor para o Brasil 🇧🇷

Prefeitura do Rio de Janeiro firma parcerias estratégicas em inteligência artificial no Rio Innovation Week.

Brasil será protagonista mundial em data centers, diz VP da Siemens Energy.

Piauí quer empréstimo de US$ 60 milhões com o BID para data center dedicado à Inteligência Artificial.

Mais notícias ao redor do mercado de IAs

DEALISM lança o primeiro agente de IA do mundo projetado para capacitar profissionais de vendas individuais para o WhatsApp Business.

Cohere atinge avaliação de US$ 6,8 bilhões com investidores AMD, Nvidia e Salesforce dobrando investimentos.

O aplicativo móvel do ChatGPT gerou US$ 2 bilhões até o momento e rende US$ 2,91 por instalação.

Senador Hawley investigará Meta após relatório descobrir que seus chatbots de IA flertam com crianças.

Bichos de pelúcia com tecnologia de IA estão chegando.

A NVIDIA pretende resolver os problemas da IA com várias linguagens.

Anthropic tem novas regras para um cenário de IA mais perigoso.

Sam Altman diz que "sim", a IA está em uma bolha.

Empresas de tecnologia estão tentando remodelar as redes elétricas em nome da IA

A explosão da IA não está mudando apenas a forma como trabalhamos ou interagimos com máquinas, está começando a reconfigurar o sistema de energia elétrica. O avanço de modelos cada vez maiores e mais famintos por processamento está forçando uma revisão profunda nas redes de energia, nos custos de eletricidade e até na arquitetura da infraestrutura energética global. Datacenters voltados para IA já consomem o equivalente a cidades inteiras, pressionando não só a oferta, mas também a estabilidade do fornecimento.

Governos e empresas agora são obrigados a repensar como lidar com essa demanda explosiva: desde parcerias para modernizar hidrelétricas e expandir energias renováveis, até estratégias de realocação de datacenters para regiões com excedente de energia. A pressão vai além da geração, inclui a necessidade de redes mais inteligentes e flexíveis, capazes de lidar com picos imprevisíveis de consumo.

O impacto também chega à conta do consumidor. Autoridades alertam que a competição entre IA e uso residencial/industrial por eletricidade pode inflar tarifas em diversos países, especialmente onde o sistema elétrico já opera próximo ao limite. Esse cenário reabre discussões sobre regulação: quem deve pagar pela energia bilionária necessária para treinar e rodar IAs, as empresas ou a sociedade?

Por que isso importa: a corrida pela IA também é física. Cada nova geração de modelos exige uma quantidade colossal de energia, e a forma como governos e empresas equilibrarem esse consumo pode definir tanto a velocidade da inovação quanto o custo social dessa revolução. No fim, a batalha por inteligência artificial também é uma batalha por energia.

Conteúdos extras para você

▶️ Sam Altman diz que a OpenAI adotou um tom 'muito mais caloroso' para o GPT-5 | Acesse o conteúdo completo aqui.

▶️ GPT-5 aumenta a rivalidade empresarial com a Anthropic | Acesse o conteúdo completo aqui.

🧠 IA ajuda a montar 'cérebro' de futuro computador quântico | Acesse o conteúdo completo aqui.

ℹ️ Você está disposto a pagar US$ 100 mil por ano por desenvolvedor em IA? | Acesse o conteúdo completo aqui.

🧠 MIT: Como a IA pode acelerar o desenvolvimento de vacinas de RNA e outras terapias de RNA | Acesse o conteúdo completo aqui.

🧠 Ensinando o modelo: projetando ciclos de feedback de LLM que se tornam mais inteligentes ao longo do tempo | Acesse o conteúdo completo aqui.

ℹ️ Esse modelo de IA de código aberto 'barato' está, na verdade, consumindo seu orçamento de computação | Acesse o conteúdo completo aqui.

|  |  |

Isso é tudo por hoje!

Dê o próximo passo e tenha palestras e treinamentos com a

nossa equipe na sua empresa. Clique aqui para se cadastrar.

Até amanhã.

Reply