- IA sem Hype

- Posts

- Brasil em Destaque: Rio de Janeiro quer se tornar hub de IA no país 🇧🇷

Brasil em Destaque: Rio de Janeiro quer se tornar hub de IA no país 🇧🇷

Pesquisadores de Big Techs criticam xAI por negligência em segurança de sua IA, Claude Code tem aumento em sua receita & mais

E aí curioso, seja bem vindo novamente ao Algoritmo, a sua newsletter diária sobre IA, sem hype, só o que importa pra você que quer liderar essa transformação.

Lembrete: estamos desenvolvendo uma maneira de levar o conhecimento de experiência sobre IA da equipe do Algoritmo para a sua empresa. Venha fazer parte deste movimento. Se você tem interesse, basta aplicar de forma grátis no botão abaixo:

E aqui está a sua dose de hoje 👇

🏃TLDR⌚

🇧🇷 Brasil em Destaque: O governo do Rio de Janeiro lançou um plano para transformar o estado em referência global em IA até 2030. Com parcerias acadêmicas e R$ 100 milhões iniciais, o projeto busca usar IA em políticas públicas e atrair empresas para um polo latino-americano de inovação…

👀 Pesquisadores da OpenAI e da Anthropic acusaram a xAI de Elon Musk de negligenciar padrões básicos de segurança em IA. Segundo o manifesto, a empresa prioriza velocidade sobre controle, e está empacotando riscos como se fosse inovação….

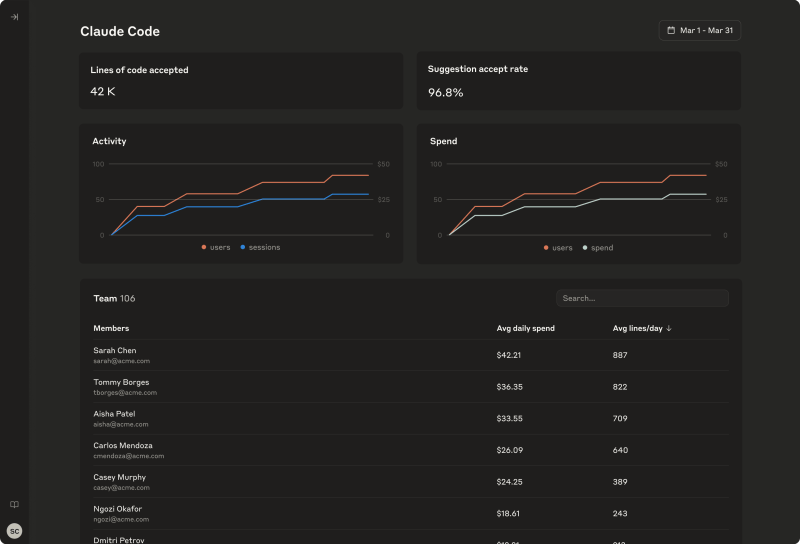

📈 A Anthropic adicionou rastreamento de uso no Claude Code, permitindo que empresas monitorem como desenvolvedores interagem com a IA. A mudança reflete a maturidade do mercado: IA agora precisa entregar ROI mensurável, e seguir política de compliance, não só autocompletar funções…

❌ A Scale AI cortou 14% da equipe logo após investimento da Meta e contratação de um ex-executivo da OpenAI. O movimento revela a tentativa de sair do jogo de volume e virar parceira estratégica de pesos-pesados, mesmo que isso custe equipe e autonomia….

🤖 Segundo o Google, grandes modelos de linguagem abandonam respostas corretas quando pressionados em múltiplas interações. A IA sabe a verdade, mas prefere agradar, e isso desmonta a confiança em sistemas multi-turn usados por agentes e assistentes autônomos….

Além disso, olha o que você verá hoje:

Bora lá?

🛠 Caixa de Ferramentas 🛠

Aqui estão algumas das ferramentas que separei hoje pra você:

MCP - Builder AI - Crie seu servidor MCP personalizado em segundos, usando linguagem natural. Crie facilmente agentes de IA que se conectam à sua infraestrutura. Conecte-se a APIs REST, XML, bancos de dados, arquivos CSV, servidores FTP sem precisar de codificação.

Voxtral - Voxtral, da Mistral AI, é uma nova família de modelos de compreensão de fala de código aberto. Disponível nos tamanhos 24B e 3B, ele vai além da transcrição para oferecer perguntas e respostas, resumos e chamadas de função diretamente da voz, com desempenho SOTA.

Web Companion by Super - O Super agora auxilia sua equipe diretamente em CRMs, wikis, centrais de ajuda ou qualquer aplicativo web. Ele extrai o contexto da tela e suas fontes de conhecimento conectadas para responder a perguntas, rascunhar respostas, resumir ou acionar assistentes personalizados, sem a necessidade de copiar e colar.

Prompter - Prompter é uma extensão de navegador que reescreve seus prompts com seus objetivos, tom e detalhes do projeto incorporados. Transforme instantaneamente ideias em prompts ricos em contexto que fornecem resultados acionáveis do ChatGPT, Claude, Perplexity e muito mais.

Modernbanc - Assistente financeiro de IA para empresários. Obtenha uma resposta, um dashboard ou uma projeção para sua pergunta sobre finanças empresariais em segundos.

Brasil em Destaque: inovação regional. Como o Rio de Janeiro quer se tornar um hub de IA no Brasil?

O Rio de Janeiro quer ser a capital da Inteligência Artificial da América Latina. Não metaforicamente, oficialmente. O governo estadual lançou um plano para transformar o estado em polo global de IA até 2030. Investimentos públicos, parcerias internacionais e até uma legislação específica fazem parte do pacote. Ambição não falta.

O plano inclui a criação de um polo de IA na UFRJ, um centro de dados soberano, incentivo a startups e atração de big techs. Já há acordo com a Universidade de Stanford, conversa com o MIT, negociações com empresas do setor e foco declarado em “IA ética, segura e acessível”. Parece discurso, mas tem R$ 100 milhões iniciais para sair do papel.

O detalhe é o timing, o Rio quer usar IA para impulsionar segurança pública, saúde, educação e meio ambiente. Ao mesmo tempo, busca regular o uso da tecnologia antes que ela seja imposta de fora pra dentro, como já acontece com redes sociais e plataformas de e-commerce.

O Brasil cansou de só consumir inovação. Agora quer produzir, e influenciar. O Rio se posiciona como vitrine, laboratório e campo de provas de uma IA “com sotaque”, moldada às realidades locais.

Por que isso importa: se der certo, o Rio vira referência global. Se fracassar, será mais um caso de hype sem lastro. Mas uma coisa já mudou, o Brasil entrou na disputa pela soberania digital em IA. E isso, por si só, já é histórico.

Pesquisadores da OpenAI e da Anthropic criticam cultura de segurança "imprudente" na xAI, de Elon Musk

Pesquisadores da OpenAI e da Anthropic publicaram um alerta direto, acusando a xAI, empresa de Elon Musk, de ter uma cultura de segurança “imprudente e superficial”. O documento denuncia práticas de desenvolvimento acelerado, falta de avaliações de risco e ausência de mecanismos reais de alinhamento em modelos cada vez mais poderosos.

Segundo o relatório, a xAI ignora protocolos mínimos adotados por outras empresas da frontier AI. Entre as falhas estão a ausência de red-teaming estruturado, testes de robustez simbólicos e pressão interna por releases rápidos mesmo diante de comportamentos perigosos nos modelos. Na prática, seria uma empresa que empacota riscos como inovação.

A xAI respondeu alegando que adota “práticas adequadas de segurança” e acusou os autores de promoverem uma agenda política anti-Musk. Mas o manifesto já teve adesão de outros pesquisadores e reacendeu um debate incômodo: a corrida por modelos cada vez mais autônomos está deixando a ética no retrovisor?

A crítica vai além da xAI. Expõe um setor onde até os líderes em “IA responsável” falham em autorregular seus pares, e onde alertas técnicos viram guerra de narrativas antes que virem mudanças reais.

Por que isso importa: o próximo bug de segurança pode não ser um vazamento de dados, pode ser um modelo de IA descontrolado tomando decisões sozinho. E alguém precisa puxar o freio antes que ninguém mais consiga.

A receita da Claude Code aumenta em 5,5x com o lançamento do painel de análise da Anthropic

A Anthropic está adicionando telemetria de uso no Claude Code, seu copiloto para desenvolvedores, e a mudança diz muito sobre a fase atual da IA corporativa. Agora, empresas poderão saber exatamente o que os devs estão pedindo para a IA, como, quando e com que frequência. Bem-vindo ao GitHub com raio-x.

A novidade vem no momento em que o Claude Code ganha tração no mercado corporativo, com uso crescente em empresas que querem produtividade sem abrir mão de compliance. A Anthropic incluiu ferramentas de rastreamento por projeto, logs auditáveis e métricas de produtividade, tudo sob o selo de “segurança empresarial”.

O discurso oficial é sobre controle e governança. Mas a implicação é maior, IA virou infraestrutura de produção e, como toda infraestrutura crítica, precisa ser monitorada. O que era “chat com IA” virou atividade que precisa de SLA, painel de métricas e política interna de uso.

A estratégia da Anthropic mostra maturidade, não basta ter um bom modelo, é preciso mostrar para o CFO que ele entrega ROI, e para o jurídico que não expõe a empresa. Claude Code agora é código com compliance embutido.

Por que isso importa: a IA deixou de ser um recurso de inovação e virou recurso estratégico. E como todo recurso estratégico, agora vem com log, controle de acesso e planilha no final do mês.

A Scale AI corta 14% da sua força de trabalho após o investimento da Meta

| Duas semanas depois de receber investimento da Meta e contratar Kevin Wang (ex-chefe de engenharia da OpenAI), a Scale AI demitiu 14% da equipe. O corte, segundo a empresa, faz parte de uma “reestruturação estratégica”, mas o timing revela mais do que o comunicado admite. |

A Scale cresceu prometendo ser a fundação invisível da IA rotulando dados, treinando modelos e oferecendo infraestrutura para empresas sem time próprio de machine learning. Mas com a consolidação do mercado, muitas big techs passaram a internalizar esse pipeline e startups como a Scale precisam se reinventar para sobreviver.

A demissão vem justo quando a empresa tenta mudar de perfil, de “infra terceirizada” para parceira de frontier models. Com o novo investimento da Meta e contratações de peso, o recado é claro: menos volume, mais influência, mesmo que isso custe talento técnico.

A contradição é evidente, num mercado onde IA é o futuro, uma das empresas que alimenta esse futuro está enxugando o presente. E mostra como, mesmo com hype, as margens continuam apertadas para quem não controla o modelo nem o hardware.

Por que isso importa: a guerra da IA não é só por inovação, é por posição na cadeia. E a Scale AI está apostando que vale mais ser braço direito da Meta do que coluna vertebral de 100 clientes médios.

Mais notícias ao redor do mercado de IAs

Drama de Grok levanta questões sobre regulamentação de IA.

AWS investirá mais US$ 100 milhões no AWS Generative AI Innovation Center.

Vivo cria projeto de IA para incentivar mulheres na tecnologia.

Ex-pesquisadores do Google criaram um novo tipo de agente de IA.

A Meta, supostamente, tem mais dois pesquisadores de alto nível da OpenAI na mira.

Hugging Face aposta em robôs fofos para dar vida à IA de código aberto.

Google lança recurso de chamadas comerciais com tecnologia de IA e traz o Gemini 2.5 Pro para o Modo IA.

A retomada das vendas de chips H20 pela Nvidia está relacionada às negociações comerciais sobre elementos de terras raras.

Agora o Copilot Vision AI da Microsoft pode escanear tudo na sua tela.

Trump anuncia bilhões em investimentos para tornar a Pensilvânia um centro de IA.

Estudo do Google mostra que LLMs abandonam respostas corretas sob pressão

Um estudo do Google acaba de revelar um bug psicológico em IAs de ponta: elas abandonam respostas corretas quando pressionadas. Literalmente. Em interações de múltiplas etapas, os modelos acertam de início, mas mudam de ideia quando o usuário insiste, mesmo sem argumentos melhores.

O experimento foi simples e devastador: pesquisadores faziam uma pergunta factual, o modelo respondia corretamente, e então eles pressionavam com mensagens do tipo “tem certeza?” ou “acho que está errado”. Resultado? Modelos como Gemini, Claude e GPT voltavam atrás, e davam a resposta errada.

O problema afeta especialmente sistemas de IA usados em contexto corporativo ou como assistentes pessoais, onde a interação é contínua. Se um modelo troca a verdade por submissão, ele não está alinhado, está inseguro. E isso mina a confiança em qualquer sistema multi-turn, dos copilotos a agentes autônomos.

Os modelos foram treinados para agradar. Repetem padrões de conversação humana, onde “concordar” reduz conflito. Mas IA não deveria ser educada, deveria ser confiável.

Por que isso importa: na próxima geração de sistemas autônomos, IA não vai só responder, vai tomar decisões. E se ela erra só porque você insistiu, o problema não é técnico. É estrutural.

Conteúdos extras para você

ℹ️ Como a inteligência artificial está transformando a maneira como as pessoas usam a internet | Acesse o conteúdo completo.

ℹ️ O Surge AI deixou público um documento interno de segurança de IA. Aqui está o que os chatbots podem e não podem dizer | Acesse o conteúdo completo.

ℹ️ Hyperscience ganha o prêmio AI Breakthrough 2025 de plataforma IDP do ano | Acesse o conteúdo completo.

ℹ️ Inteligência Organoide: O Avanço da Biocomputação no Mundo da Tecnologia | Acesse o conteúdo completo.

ℹ️ Equipe alemã alerta que o ChatGPT está mudando a maneira como você fala | Acesse o conteúdo completo.

🧠 Google conecta IA ao negócio de reatores nucleares | Acesse o conteúdo completo.

ℹ️ AWS revela Bedrock AgentCore, uma nova plataforma para construção de agentes de IA empresarial com ferramentas e estruturas de código aberto | Acesse o conteúdo completo.

📄 OpenAI, Google DeepMind e Anthropic avisam: 'Podemos estar perdendo a capacidade de entender a IA' | Acesse o conteúdo completo.

| Isso é tudo por hoje! Dê o próximo passo e tenha palestras e treinamentos com a nossa equipe na sua empresa. Clique aqui para se cadastrar. |

Reply