- IA sem Hype

- Posts

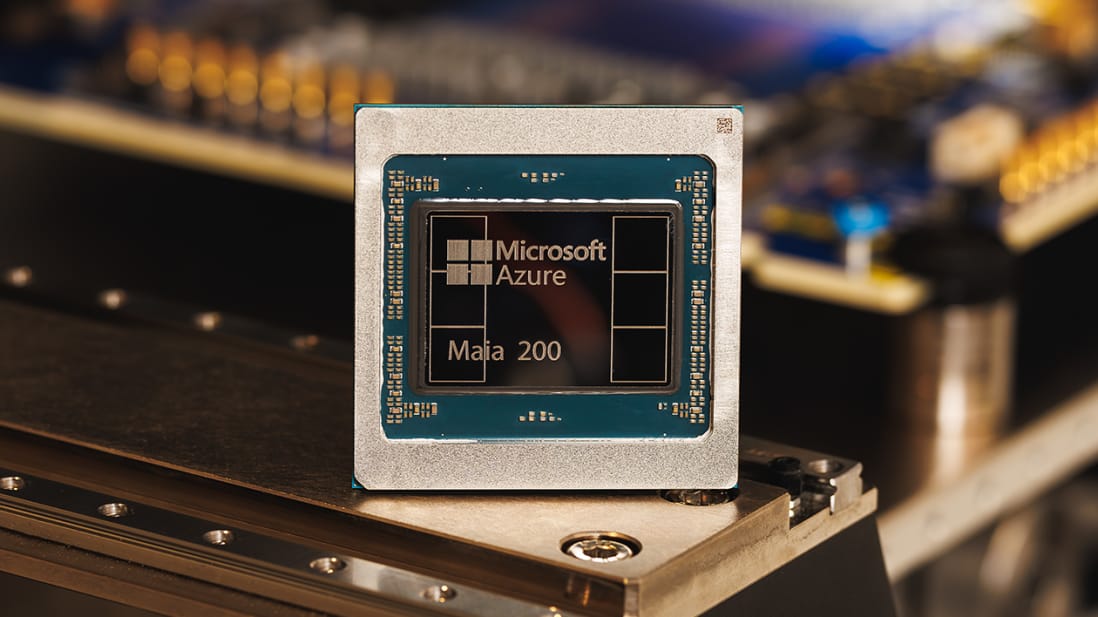

- Microsoft lança chip focado em inferência de IA

Microsoft lança chip focado em inferência de IA

ChatGPT usa dados do Grok, Nvidia amplia compute, Anthropic integra IA ao trabalho & mais...

E aí curioso, seja bem-vindo À IA sem hype.

🤖 A Microsoft anunciou um novo chip próprio focado em inferência de IA, reforçando a estratégia de reduzir dependência de GPUs tradicionais e otimizar custo, desempenho e eficiência energética em larga escala.

E não foi só isso, veja o que preparamos para você hoje.

⚠️ Testes independentes indicam que versões recentes do ChatGPT estão usando conteúdo da Grokipedia, base gerada por IA ligada ao projeto Grok de Elon Musk, levantando alertas sobre circularidade de dados e degradação da qualidade informacional.

💰 A Nvidia investiu US$ 2 bilhões na CoreWeave para ajudar a empresa a expandir em até 5 GW de capacidade computacional para IA, reforçando o papel do capital e da energia como gargalos centrais da corrida por infraestrutura de IA.

💻 A Anthropic lançou apps interativos do Claude integrados a ferramentas de trabalho como Slack e outros softwares corporativos, ampliando o uso da IA diretamente nos fluxos diários das empresas.

| Impulsione seu funil de vendas com agentes de IADo primeiro contato ao pós-venda, seus agentes de IA trabalhando 24 horas por dia para gerar, converter e expandir receita. Clique no link abaixo e leve a revolução para sua empresa. |

Novo chip da Microsoft mira eficiência na fase mais cara da IA

A Microsoft revelou um novo chip desenvolvido internamente para acelerar inferência de modelos de inteligência artificial, ou seja, a fase em que modelos já treinados geram respostas em tempo real. O anúncio posiciona o chip como alternativa especializada às GPUs convencionais, com foco em baixa latência, maior eficiência energética e custos operacionais mais previsíveis.

Segundo a empresa, o chip foi projetado para atender cargas de trabalho típicas de produtos como Copilot, Azure AI e serviços corporativos que exigem respostas rápidas e escaláveis. Ao otimizar especificamente inferência, a Microsoft busca melhorar desempenho em aplicações do dia a dia, onde o volume de requisições é muito maior do que o treinamento de novos modelos.

O movimento segue uma tendência clara entre big techs: internalizar partes críticas da infraestrutura de IA. Com escassez de GPUs e custos elevados, empresas como Microsoft, Google e Amazon estão investindo em silício próprio para ganhar controle sobre a economia da IA e reduzir gargalos externos.

O novo chip também reforça a integração vertical da Microsoft, que combina hardware próprio, cloud, modelos de IA e produtos finais. Essa abordagem permite otimizações cruzadas entre software e silício, algo difícil de alcançar ao depender exclusivamente de fornecedores terceirizados.

Por que isso importa?

O foco em inferência mostra que a economia da IA está mudando de treinar modelos gigantes para servi-los de forma eficiente. Para o Brasil e a América Latina, esse movimento influencia preços, disponibilidade e acesso a serviços de IA em cloud. Também reforça que a disputa pela IA passa cada vez mais pelo controle do hardware, e quem dominar essa camada terá vantagem estrutural na próxima fase da transformação digital.

| 🇧🇷 IA generativa no Brasil 🇧🇷

|

Quando a IA começa a aprender com conteúdo gerado por IA

Investigações conduzidas por pesquisadores e jornalistas mostram que o ChatGPT passou a citar ou reproduzir informações provenientes da Grokipedia, um repositório de conhecimento criado a partir de respostas geradas por modelos de IA. O comportamento foi identificado principalmente em perguntas mais obscuras ou pouco documentadas, onde fontes humanas tradicionais são escassas.

Segundo os testes relatados, o modelo apresenta respostas que refletem padrões, frases e estruturas típicas da Grokipedia, sugerindo que conteúdo sintético está sendo usado como fonte intermediária. Isso reacende preocupações antigas no setor sobre model collapse, fenômeno em que modelos treinados ou alimentados com dados gerados por outras IAs passam a amplificar erros, vieses e simplificações ao longo do tempo.

A OpenAI não confirma explicitamente o uso direto da Grokipedia como fonte oficial, mas reconhece que modelos podem acessar conteúdos amplamente disponíveis na web, incluindo material gerado por IA. O problema não é apenas a origem, mas a dificuldade de distinguir, em escala, conhecimento humano validado de material sintético não verificado.

O caso também expõe uma ironia estrutural: à medida que a web se enche de conteúdo gerado por IA, modelos passam a “aprender consigo mesmos”, criando ciclos fechados de informação. Isso ameaça a diversidade e a confiabilidade do conhecimento digital, especialmente em domínios menos cobertos por fontes tradicionais.

Porque isso importa

A dependência crescente de conteúdo gerado por IA como fonte de outras IAs coloca em risco a qualidade da informação global. Para o Brasil e a América Latina, onde lacunas de documentação já existem em muitos temas locais, esse efeito pode amplificar erros e invisibilizar realidades regionais. O episódio reforça que o futuro da IA depende não apenas de modelos melhores, mas de ecossistemas de dados humanos, verificados e diversos, sem isso, a inteligência artificial corre o risco de se tornar um espelho cada vez mais distorcido de si mesma.

| Impulsione seu funil de vendas com agentes de IADo primeiro contato ao pós-venda, seus agentes de IA trabalhando 24 horas por dia para gerar, converter e expandir receita. Clique no link abaixo e leve a revolução para sua empresa. |

Nvidia injeta US$ 2 bilhões para acelerar a infraestrutura global de IA

A Nvidia fez um investimento direto de US$ 2 bilhões na CoreWeave, provedora de infraestrutura de IA baseada em GPUs, em um momento em que a empresa enfrenta alto endividamento, mas demanda explosiva por capacidade computacional. O aporte visa acelerar a expansão de data centers capazes de suportar cargas intensivas de treinamento e inferência de modelos avançados.

Segundo a reportagem, a CoreWeave planeja usar os recursos para adicionar até 5 gigawatts de capacidade, um volume comparável ao consumo de energia de grandes cidades. A expansão depende não apenas de hardware, mas de acesso a energia, terrenos e licenças, reforçando como a infraestrutura física se tornou o verdadeiro campo de batalha da IA.

Para a Nvidia, o investimento é estratégico. Ao apoiar um grande cliente e parceiro de infraestrutura, a empresa ajuda a garantir demanda contínua por suas GPUs e influencia diretamente a forma como a computação de IA escala no mundo real. O movimento também funciona como hedge contra gargalos de supply chain e concentração excessiva em poucos hyperscalers.

A matéria destaca que o acordo expõe uma tensão crescente no setor: provedores de compute crescem rapidamente, mas com estruturas financeiras frágeis, enquanto a demanda por IA pressiona custos de capital e energia. O resultado é um ecossistema onde crescimento acelerado e risco financeiro caminham juntos.

Porque isso importa: O investimento da Nvidia mostra que a corrida da IA não será vencida apenas por quem tem os melhores modelos, mas por quem consegue financiar e energizar a infraestrutura necessária. Para o Brasil e a América Latina, o episódio reforça a importância estratégica de energia, crédito e planejamento industrial para atrair data centers e investimentos em IA. A próxima fase da inteligência artificial será decidida tanto em balanços financeiros quanto em usinas e subestações.

🛠️ Caixa de Ferramentas 🛠

YouWare Mobile - Crie usando comandos em linguagem natural ou sua voz. Com o YouWare, a programação com IA se torna uma conversa. Sem configurações complexas. Sem necessidade de experiência em programação.

Webflow App Gen - Crie aplicativos web completos e de nível de produção com IA que incorporem seu sistema de design, componentes e coleções de CMS para corresponder à marca, ao conteúdo e à visão criativa do seu site.

Hyperlink by Nexa AI - Perplexity para seus arquivos locais. Ele transforma seu computador em um segundo cérebro de IA, 100% privado e local.

Kadabra - O agente que elimina tarefas tediosas. Você descreve o resultado desejado em texto simples, o Kadabra cria o fluxo de trabalho, testa e executa conforme agendado ou por gatilho.

Scribe v2 Realtime - Modelo de conversão de fala em texto em tempo real.

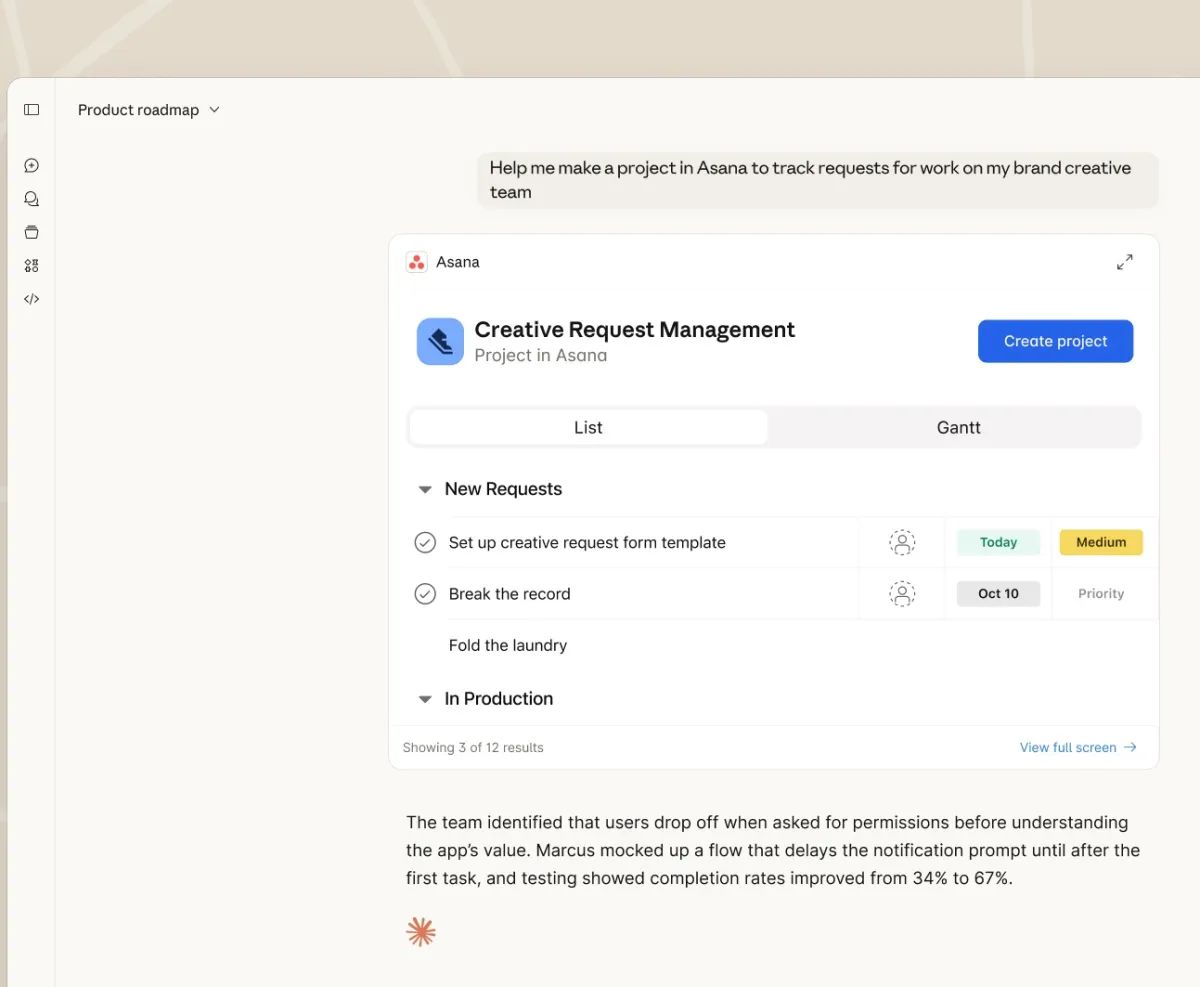

Anthropic leva o Claude direto para as ferramentas de trabalho

A Anthropic anunciou o lançamento de aplicativos interativos do Claude voltados para ambientes corporativos, com integrações diretas a ferramentas populares de trabalho, incluindo o Slack. A proposta é permitir que o modelo atue dentro dos fluxos já existentes, reduzindo fricção e aumentando adoção no dia a dia das equipes.

Os apps permitem que usuários interajam com o Claude de forma contextualizada, usando dados e conversas do próprio ambiente de trabalho. Em vez de copiar informações para um chatbot externo, a IA passa a operar onde o trabalho acontece, auxiliando em tarefas como resumo de discussões, geração de conteúdo, análise de documentos e apoio à tomada de decisão.

A iniciativa posiciona a Anthropic de forma mais direta na disputa pelo mercado corporativo, onde integração e confiabilidade são tão importantes quanto qualidade do modelo. Ao oferecer apps prontos e conectados a ferramentas amplamente usadas, a empresa reduz a barreira de entrada para equipes que não querem construir soluções personalizadas do zero.

A matéria destaca que o movimento acompanha uma tendência maior do setor: a IA deixa de ser uma camada separada e passa a se tornar funcionalidade nativa de softwares de produtividade. Para empresas, isso significa menos experimentação isolada e mais uso prático e recorrente.

Por que isso importa?

Integrar a IA diretamente às ferramentas de trabalho acelera sua transformação em infraestrutura invisível. Para o Brasil e a América Latina, esse modelo facilita adoção em empresas de todos os portes, sem exigir grandes times técnicos. Ao mesmo tempo, aumenta a dependência de fornecedores globais e reforça a necessidade de governança, segurança e clareza sobre como dados corporativos são usados por modelos de IA.

Panorama Global - O que está acontecendo ao redor do mundo

Agora é hora de dar uma olhada no que está acontecendo lá fora. Selecionamos alguns destaques do cenário global de IA que podem influenciar diretamente o que acontece por aqui. Abaixo, você encontra só o que importa, de forma rápida.

O uso frequente de IA no ambiente de trabalho continuou a aumentar no quarto trimestre de 2025.

IA superinteligente: Seu desenvolvimento deveria ser interrompido?

Semiotica Cybernetics apresenta solução para alcançar inteligência artificial geral e superinteligente.

Jeffrey Ding explica por que a difusão, e não a inovação, é o segredo para a vitória na corrida da IA.

O ano decisivo de Sam Altman: será que o CEO da OpenAI pode aproveitar sua aposta no futuro?

Gestor de Ativos alerta que a OpenAI provavelmente está caminhando para um desastre financeiro.

Empresa chinesa lança linha de produção automatizada para juntas robóticas.

Nos conte. O que você achou da edição de hoje?

Queremos saber se o conteúdo de hoje fez sentido pra você. Sua opinião ajuda a gente a melhorar a cada edição e a entregar algo que realmente faça diferença no seu dia.

Me conta: o que você achou do conteúdo de hoje? |

Faça Login ou Inscrever-se para participar de pesquisas. |

| Curtiu nossa news?Não guarda só pra você: compartilhe com quem merece estar por dentro do universo IA. Clique, envie e ajude a comunidade a crescer — simples assim. |

|  |  |

Isso é tudo por hoje!

Até amanhã.

Reply