- IA sem Hype

- Posts

- Será que o Google finalmente superou a Nvidia?

Será que o Google finalmente superou a Nvidia?

OpenAI firma US$ 1,4 tri em data centers e cientistas criam neurônios artificiais pra IA & mais...

E aí curioso, seja bem-vindo à IA sem Hype, a newsletter do Algoritmo.

🆕 O Google lançou chips de IA com desempenho 4x superior e fechou um megacontrato com a Anthropic, fortalecendo o Google Cloud e desafiando o domínio da Nvidia no compute global.

E não foi só isso, veja o que preparamos para você hoje.

💵 A OpenAI ultrapassou US$ 20 bilhões em receita anual e firmou US$ 1,4 trilhão em compromissos de data centers, consolidando-se como potência central na nova economia da IA.

🤖 A Moonshot AI lançou o Kimi K2 Thinking, modelo open source que supera rivais em raciocínio e eficiência, consolidando a China como nova força na corrida global por IA avançada.

🧠 Cientistas da USC e Delaware criaram neurônios artificiais de “wetware” que imitam o cérebro humano, prometendo IA mais eficiente e sustentável, com consumo de energia até mil vezes menor.

| Impulsione seu funil de vendas com agentes de IADo primeiro contato ao pós-venda, seus agentes de IA trabalhando 24 horas por dia para gerar, converter e expandir receita. Clique no link abaixo e leve a revolução para sua empresa. |

Google desafia Nvidia com chips de IA de próxima geração e acordo bilionário

O Google apresentou sua nova geração de chips de IA, prometendo quatro vezes mais desempenho que a versão anterior, ao mesmo tempo em que anunciou um acordo bilionário com a Anthropic para fornecer infraestrutura dedicada ao treinamento dos modelos Claude. Os chips, parte da linha TPU v6, são fabricados sob medida para cargas de trabalho de IA generativa em larga escala e otimizados para eficiência energética e treinamento distribuído.

A nova arquitetura combina unidades de processamento tensorial integradas a sistemas ópticos de interconexão, o que reduz gargalos entre GPUs e acelera o fluxo de dados em clusters com centenas de milhares de unidades. A Anthropic será uma das primeiras empresas a ter acesso exclusivo à tecnologia, expandindo seu uso do Google Cloud após o recente acordo estratégico entre as duas companhias.

Além da parceria com a Anthropic, o Google pretende usar os novos chips internamente para fortalecer o ecossistema Gemini, reduzindo dependência de fornecedores como Nvidia e ampliando o controle sobre seu pipeline de IA. A expectativa é que o novo hardware esteja disponível comercialmente para outros clientes da nuvem até 2026, consolidando o Google Cloud como plataforma de referência para IA corporativa.

Por que isso é importante?

Com a TPU v6, o Google não apenas melhora desempenho, mas entra de vez na disputa pelo domínio do compute global, hoje concentrado na Nvidia. A parceria com a Anthropic sela uma aliança estratégica que une infraestrutura e inteligência, um passo decisivo na corrida para treinar os próximos modelos de fronteira.

| 🇧🇷 IA generativa no Brasil 🇧🇷

|

OpenAI atinge US$ 20 bi em receita e fecha US$ 1,4 tri em infraestrutura de IA

A OpenAI atingiu a marca de US$ 20 bilhões em receita anual recorrente (ARR) e já tem US$ 1,4 trilhão em compromissos de data centers, segundo Sam Altman. O anúncio, feito em evento com investidores, consolida a empresa como o negócio de crescimento mais rápido da história recente da tecnologia, superando o ritmo da própria Nvidia durante o boom dos chips.

A maior parte da receita vem das assinaturas do ChatGPT (Pro e Enterprise) e da API de modelos, mas o novo ecossistema de apps e agentes, lançado em outubro, já representa quase 15% do faturamento. Altman afirmou que a demanda por capacidade de inferência e treinamento está tão alta que a OpenAI assinou contratos plurianuais de infraestrutura com Microsoft, AWS e Oracle, garantindo acesso prioritário a clusters de GPUs e chips personalizados.

A escala de investimento é inédita: o gasto em infraestrutura computacional da OpenAI em 2025 supera o PIB de países médios da América Latina, um sinal claro de que o foco estratégico migrou do produto para o domínio do compute. Altman também sugeriu que novos acordos estão em negociação com fabricantes de chips alternativos, inclusive AMD e Broadcom, para reduzir a dependência da Nvidia.

Por que isso é importante:

O número não é apenas um marco financeiro. Ele confirma que a IA generativa virou um setor industrial completo, com infraestrutura, distribuição e ecossistema próprio. O domínio da OpenAI sobre compute e receita recorrente redefine o equilíbrio de poder na tecnologia, quem controla os data centers controla o futuro da IA.

| Impulsione seu funil de vendas com agentes de IADo primeiro contato ao pós-venda, seus agentes de IA trabalhando 24 horas por dia para gerar, converter e expandir receita. Clique no link abaixo e leve a revolução para sua empresa. |

🛠️ Caixa de Ferramentas 🛠

Golf - O Golf Firewall é a camada de segurança para empresas que expõem servidores MCP. Ele protege seu servidor MCP contra o envio de dados maliciosos ou confidenciais, bloqueando injeções de prompts, vazamentos de informações pessoais.

SuperNote - Aplicativo de anotações com tecnologia de IA que ajuda você a capturar, resumir e aprender com conteúdo de fontes como YouTube, TikTok, voz, documentos e notas digitadas.

TensorBlock Forge - Uma API para conectar e executar todos os modelos de IA.

OneNode - O backend mais simples para codificação de IA.

Olive - Crie ferramentas e dashboards conectados aos seus dados de forma rápida, em um ambiente privado e hospedado que você pode compartilhar com sua equipe.

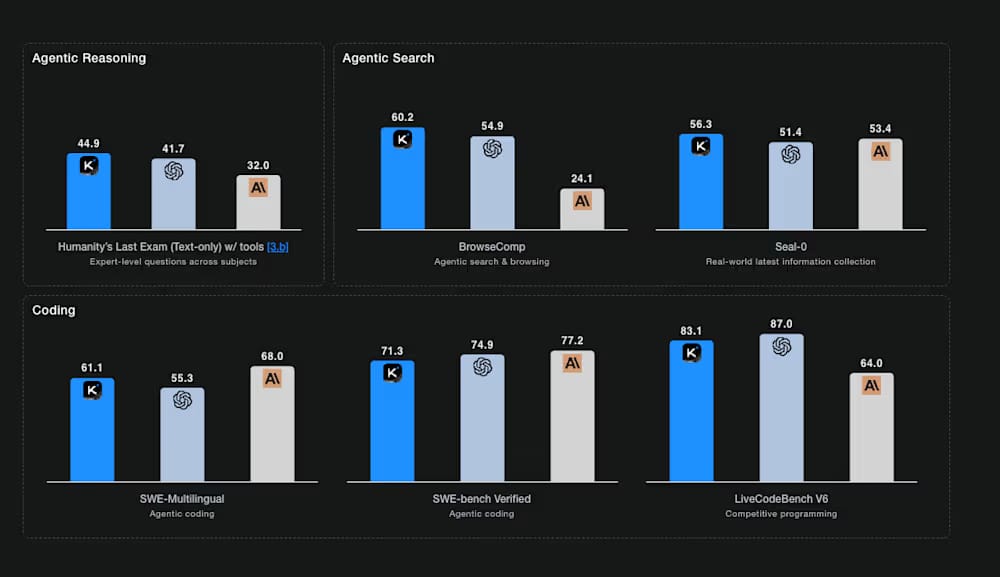

Open source chinês supera gigantes: K2 Thinking desafia GPT-5 e Claude

O Kimi K2 Thinking, novo modelo de linguagem de código aberto desenvolvido pela Moonshot AI, está superando concorrentes de peso como Llama 3.1, Mistral Large e DeepSeek-V2 em benchmarks de raciocínio e tarefas multimodais. O resultado coloca a Moonshot, uma startup chinesa, na dianteira do movimento open-source de próxima geração, mostrando que a fronteira da IA não está mais restrita ao Ocidente.

O K2 Thinking foi projetado com foco em “reasoning composicional”, uma abordagem que permite combinar múltiplas etapas de inferência para resolver problemas complexos de forma mais humana. Ele também traz avanços em interpretação contextual e geração de código, aproximando-se de modelos proprietários como o Claude 4.5 e o GPT-5 em capacidade de pensamento lógico, mas com custos de inferência até 60% menores.

Além da performance, a Moonshot aposta na abertura do modelo e na eficiência energética como diferenciais estratégicos. A empresa afirma que o K2 Thinking pode ser treinado com apenas 20% do compute usado por modelos equivalentes, graças a uma arquitetura híbrida entre transformer e memória persistente. Analistas destacam que essa eficiência pode redefinir o equilíbrio entre inovação aberta e poder computacional, abrindo espaço para ecossistemas mais acessíveis na Ásia e América Latina.

Por que isso é importante: o avanço da Moonshot com o K2 Thinking mostra que a supremacia dos modelos proprietários está sendo desafiada. Se o open source conseguir competir em raciocínio e eficiência, o mercado de IA pode se fragmentar novamente, desta vez em favor da democratização do compute e da diversidade geopolítica da inovação.

| Impulsione seu funil de vendas com agentes de IADo primeiro contato ao pós-venda, seus agentes de IA trabalhando 24 horas por dia para gerar, converter e expandir receita. Clique no link abaixo e leve a revolução para sua empresa. |

Neurônios artificiais abrem caminho para a IA híbrida, biológica e digital

Pesquisadores da Universidade do Sul da Califórnia (USC) e da Universidade de Delaware desenvolveram uma tecnologia de neurônios artificiais baseados em “wetware”, componentes que imitam o funcionamento biológico do cérebro humano para criar sistemas de IA mais eficientes e menos dependentes de energia. O estudo, publicado na Science Advances, descreve como circuitos híbridos feitos com materiais orgânicos condutores e eletrônica tradicional conseguem replicar sinais sinápticos e plasticidade neural com alta precisão.

Esses “neurônios artificiais molhados” operam em temperaturas ambientes, consomem até mil vezes menos energia que chips de silício e são capazes de aprender de forma autônoma, ajustando conexões internas conforme padrões de estímulo, um comportamento idêntico ao de sinapses biológicas. O avanço coloca a pesquisa no campo da computação neuromórfica, uma das áreas mais promissoras para o futuro da IA sustentável.

Segundo os cientistas, o objetivo é construir sistemas de IA que pensem e aprendam como o cérebro, mas com capacidade de integração em arquiteturas digitais. A próxima fase inclui a criação de redes com milhões desses neurônios artificiais, capazes de processar linguagem, visão e tomada de decisão em tempo real, sem a pegada energética massiva dos data centers atuais.

Por que isso é importante?

O avanço representa um salto na busca por IA de baixa energia e alta cognição, aproximando a engenharia da biologia. Se os neurônios de “wetware” se provarem escaláveis, poderão redefinir o design de chips e abrir caminho para uma nova geração de inteligência híbrida, metade biológica, metade sintética.

Zona Técnica

ℹ️ A inteligência artificial que transforma os negócios começa com os humanos | Acesse o conteúdo completo.

🧠 Google descobre malware PROMPTFLUX que usa Gemini AI para reescrever seu código de hora em hora | Acesse o conteúdo completo.

ℹ️ Cinco dicas para usar inteligência artificial no atendimento | Acesse o conteúdo completo.

🧠 Explorando um design de sistema de infraestrutura de IA escalável e baseado no espaço | Acesse o conteúdo completo.

🧠 À medida que a IA se torna mais poderosa, entender a consciência se tornou uma questão urgente | Acesse o conteúdo completo.

▶️ Vídeo mostra robô de IA manipulando e 'sequestrando' 12 outros robôs? | Acesse o conteúdo completo.

❔ Será que o Google e a SRL da UCLA conseguirão desbloquear a verdadeira inteligência artificial? | Acesse o conteúdo completo.

ℹ️ As principais armas da China em sua batalha de IA contra os EUA, enormes clusters de chips da Huawei e energia barata | Acesse o conteúdo completo.

Nos conte. O que você achou da edição de hoje?

Queremos saber se o conteúdo de hoje fez sentido pra você. Sua opinião ajuda a gente a melhorar a cada edição e a entregar algo que realmente faça diferença no seu dia.

Me conta: o que você achou do conteúdo de hoje? |

Faça Login ou Inscrever-se para participar de pesquisas. |

| Curtiu nossa news?Não guarda só pra você: compartilhe com quem merece estar por dentro do universo IA. Clique, envie e ajude a comunidade a crescer — simples assim. |

|  |  |

Isso é tudo por hoje!

Até amanhã.

Reply